Ученые Калифорнийского университета в Беркли создали алгоритм, который воссоздает жесты человека по его речи.

Об этом сообщается на сайте университета.

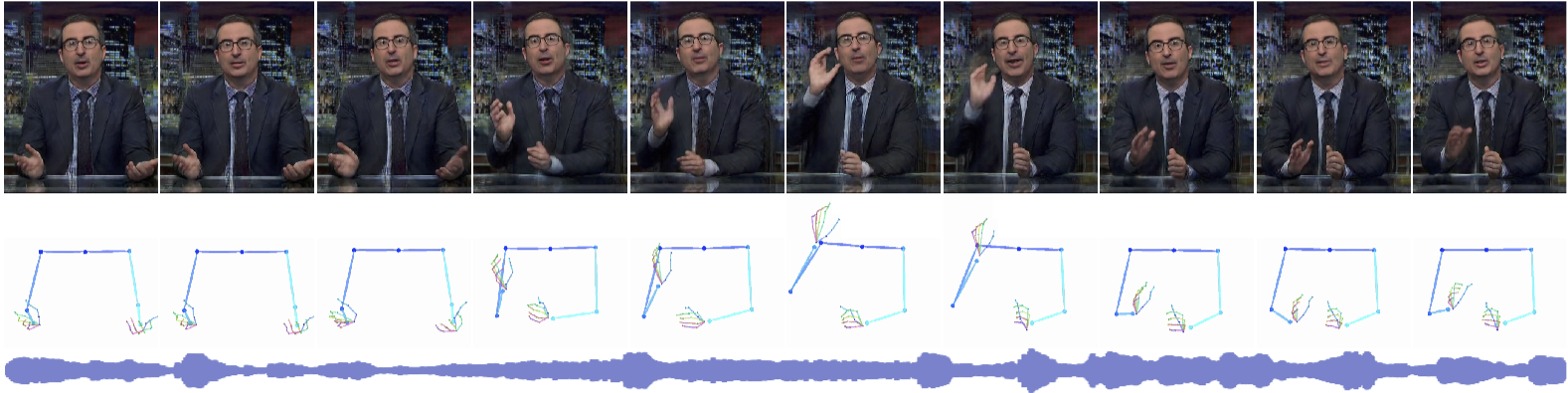

В исследовании отмечается, что человеческая речь часто сопровождается жестами. Исследователи из Калифорнийского университета в Беркли использовали эту связь для предсказания жестикуляции человека в разговоре на основе голосовой составляющей его речи. Работу алгоритма можно разбить на два этапа: сначала алгоритм на базе сверточной нейросети UNet предсказывает жесты по аудио, а затем визуализирует последовательность поз.

Исследователи обучили нейросеть на датасете из аудио- и видеозаписей телеведущих, лекторов и религиозных проповедников общей длительностью 144 часа.

На видео видно, что некоторые движения не полностью соответствуют реальным жестам человека на исходной записи. Часто алгоритм подбирает верное движение, но использует другую руку, отмечается в работе.

- В 2017 году некоммерческая исследовательская организация OpenAI презентовала новый способ обучения роботов.

- Разработчики популярного веб-сайта ThisPersonDoesNotExist научили нейросеть генерировать фотографии виртуальных людей и несуществующих котов.

Антиукраїнські заяви Трампа: маніпуляції та реакція світової спільноти

Антиукраїнські заяви Трампа: маніпуляції та реакція світової спільноти